脳の主要な器官の機能とモデル

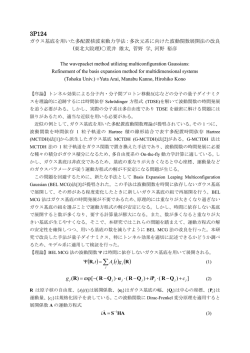

脳の主要な器官の機能とモデル 第4回全脳アーキテクチャ勉強会 2014-06-02 産業技術総合研究所 ヒューマンライフテクノロジー研究部門 一杉裕志 自己紹介 • 1990年東京工業大学大学院情報科学専攻 修士課程修了。米澤研究室。 • 1993年東京大学大学院情報科学専攻博士 課程修了。博士(理学)。 • 同年電子技術総合研究所入所。 – 並列言語、拡張可能言語、オブジェクト指向言語 のモジュール機構、スクリプト言語等を研究。 • 2001年より産業技術総合研究所に改組。 • 2005年より計算論的神経科学を研究。 脳の各器官のモデル 脳を構成する主な要素 運動野 前頭前野 言語野 視覚野 大脳皮質 基底核 扁桃体 海馬 小脳 脳の各器官の機械学習装置としての モデル 大脳皮質: SOM、ICA、ベイジアンネットワーク 大脳基底核、扁桃体: 強化学習 小脳: パーセプトロン、リキッドステートマシン 海馬: 自己連想ネットワーク 主な領野の情報処理装置としての役 割 視覚野: deep learning 運動野: 階層型強化学習 前頭前野: 状態遷移機械? 言語野: チャートパーサ? 脳の知能に関係する主要な器官の計算論的モデルは不完全ながら出 そろってきている。これらの器官の間の連携のモデルを考えることで、 脳全体の機能の再現に挑戦すべき時期に来ている。 脊椎動物の 「全脳アーキテクチャ」の特徴は何? • 高い汎用性。 – 万能の意思決定装置である大脳基底核と、 万能の連想記憶装置である海馬の両方を備えてい る。 – コンピュータと似ている。 • プログラム(データ構造とその処理手順)を自分 で獲得する。 – 原理はおそらく教師なし学習・強化学習。 – ただし脳は非常に性能が良い。 → 脳に学ぶべき! 大脳皮質の機能とモデル 大脳皮質 • 脳の中でも知能をつかさどる重要な部分。 – 視覚野、言語野、運動野、前頭前野、・・・ 図は http://en.wikipedia.org/wiki/Brodmann_area より 大脳皮質の領野 • 各領野の機能、接続構造はそれなりに明らか になっている。 Daniel J. Felleman and David C. Van Essen Distributed Hierarchical Processing in the Primate Cerebral Cortex Cerebral Cortex 1991 1: 1-47 視覚系領野 運動野 大脳皮質のコラム構造の模式図 ミニコラム 50μm マクロコラム 500μm I II III IV V VI I II III IV V VI 厚さ約2ミリ ニューロン(神経細胞) • ヒトの脳で1000億個。 • 内積計算のような簡単な演算しか行えない。 • シナプスが w という重みを学習。 x1 w1 x2 . . . w2 xn ニューロンへの入力 wn シナプス y = φ (∑ wi xi ) i ニューロンからの出力 大脳皮質の各スケールでの構造 • • • • • Wikipedia より Daniel J. Felleman and David C. Van Essen Distributed Hierarchical Processing in the Primate Cerebral Cortex Cerebral Cortex 1991 1: 1-47 マクロコラム ミニコラム I II III IV V VI I II 厚さ約2ミリ III IV V VI x1 w2 x2 . . wn . xn w1 シナプス y = φ (∑ wi xi ) i ニューロンからの出力 領野 約50個 マクロコラム約100万個 ミニコラム 約1億個 ニューロン 約100億個 シナプス 約100兆個 大脳皮質の不思議さ • 脳の様々な高次機能 (認識、意思決定、運動 制御、思考、推論、言語 理解など)が、たった50 個程度の領野のネット ワークで実現されている。 Wikipedia より Daniel J. Felleman and David C. Van Essen Distributed Hierarchical Processing in the Primate Cerebral Cortex Cerebral Cortex 1991 1: 1-47 マクロコラム ミニコラム I II III IV V VI I II 厚さ約2ミリ III IV V VI x1 w2 x2 . . wn . xn w1 シナプス y = φ (∑ wi xi ) i ニューロンからの出力 ベイジアンネット[Pearl 1988]とは • 脳の「直感・連想記憶」と似た働きをする。 • 確率変数の間の因果関係をグラフで効率的 に表す知識表現の技術。 雲が出ている スプリンクラー が動く P(芝生 | スプリンクラー,雨) Node = 確率変数 Edge = 因果関係 雨が降る P(雨|雲) P(S=yes) 0.2 芝生が ぬれる S no no yes yes R no yes no yes P(R=yes) 0.02 P(W=yes|S,R) 0.12 0.8 0.9 0.98 R P(C=yes|R) no 0.3 yes 0.995 大脳皮質とベイジアンネットの 類似点 – トップダウンとボトムアップの非対称の接続 – 局所的かつ非同期な情報のやり取りだけで動作 – 値が非負 – 情報が正規化される – ヘブ則学習 – 文脈や事前知識に依存した認識 – ベイズに基づく動作 Daniel J. Felleman and David C. Van Essen Distributed Hierarchical Processing in the Primate Cerebral Cortex Cerebral Cortex 1991 1: 1-47 ベイジアンネットを使った大脳皮質 モデル • 視覚野の機能、運動野の機能、解剖学的構 造、電気生理学的現象などを説明 • • • • • • • • • • [Lee and Mumford 2003] [George and Hawkins 2005] [Rao 2005] [Ichisugi 2007] [Ichisugi 2010] [Ichisugi 2011] [Ichisugi 2012] [Rohrbein, Eggert and Korner 2008] [Hosoya 2009] [Hosoya 2010] [Hosoya 2012] [Litvak and Ullman 2009] [Chikkerur, Serre, Tan and Poggio 2010] [Hasegawa and Hagiwara 2010] [Dura-Bernal, Wennekers, Denham 2012] 近似確率伝搬アルゴリズム[Ichisugi 2007] t +1 = zYt + W XY oYt l XY Pearl のアルゴリズム[Pearl 1988]をいくつか の仮定のもとで近似。 ⊗ t +1 l ∏ XY o tX+1 = Y ∈children ( X ) t +1 T = WUX kUX bUt p t +1 X t +1 X r Z t +1 X = U ∑k bU t +1 UX U ∈ parents ( X ) =o t +1 X ⊗p bX = ∑ (r ) (= r i t +1 X 1 =o z tX+1 = ( Z Xt +1 , Z Xt +1 , , Z Xt +1 )T bXt +1 = (1 / Z Xt +1 )rXt +1 Z X , oX X t +1 X t +1 X i WUX t +1 X t +1 X •p ) WXY Z Y , οY Y ・神経回路で実現可能 ・大規模化可能な計算量・記憶量 ただし、x ⊗ y = ( x1 y1 , x2 y2 , , xn yn )T コラム構造・6層構造との一致 [Gilbert 1983] I II III IV V VI 低次領野 高次領野 解剖学的構造 kUX oX [Pandya and Yeterian 1985] Pandya, D.N. and Yeterian, E.H., Architecture and connections of cortical association areas. In: Peters A, Jones EG, eds. Cerebral Cortex (Vol. 4): Association and Auditory Cortices. New York: Plenum Press, 3-61, 1985. Gilbert, C.D., Microcircuitry of the visual-cortex, Annual review of neuroscience, 6: 217-247, 1983. lUX bU k XY oY l XY ZX bX ZY 個ノード 親ノード モデル I II III IV V VI 各変数の値を計算する回路 (bU1 )1 (bU1 ) 2 I (bU 2 ) 3 (bU 2 )1 + (bU 2 ) 2 + (kU1 X )1 (kU1 X ) 2 + (bU 2 ) 3 + + ( p X )1 (o X )1 (l XY1 )1 II + (kU 2 X )1 (kU 2 X ) 2 U1 U2 ( pX )2 (o X ) 2 (rX )1 III (rX ) 2 + X Z Y1 (l XY1 ) 2 (oY1 )1 + (oY1 ) 2 (l XY2 )1 + (l XY2 ) 2 (oY1 ) 3 + Z Y2 (oY2 )1 IV (oY2 ) 2 / ZX ZX (bX )1 / (oY2 ) 3 (b X ) 2 + (o X )1 (bX )1 (o X ) 2 (b X ) 2 V VI Y1 Y2 左図は、上記 BESOMネットワー クのノードXのユ ニットの値を計算 する回路 大脳皮質の構造との一致 2層、4層の細かい細胞 BEL(U1 = u11 ) BEL(U1 = u12 ) I BEL(U1 = u31 ) BEL(U 2 = u ) 2 1 + BEL(U 2 = u22 ) + κU ( X = x1 ) + 1 BEL(U 2 = u32 ) κ U ( X = x2 ) + 1 κU ( X = x1 ) 2 2 + + π ( X = x2 ) π ( X = x1 ) λ ( X = x1 ) II κ U ( X = x2 ) λ ( X = x2 ) ρ ( X = x1 ) λY ( X = x1 ) 1 + III Z Y1 λY ( X = x2 ) 1 ρ ( X = x2 ) λ (Y1 = y11 ) + λ (Y1 = y12 ) λY ( X = x1 ) 2 + λ (Y1 = y31 ) λY ( X = x2 ) + 2 Z Y2 λ (Y2 = y12 ) IV λ (Y2 = y22 ) ZX / / BEL( X = x1 ) BEL( X = x2 ) λ (Y2 = y32 ) + ZX λ ( X = x1 ) λ ( X = x2 ) BEL( X = x1 ) BEL( X = x2 ) K. Brodmann, Vergleichende Lokalisation der Grosshirnrinde. in: ihren Prinzipien dargestellt auf Grund des Zellenbaues,. J.A. Barth, Leipzig, 1909. This figure is taken from the following Web page. http://web.sc.itc.keio.ac.jp/anatomy/brodal/chapter12.html V VI 1層、4層の 水平線維 他の主な器官のモデル • 大脳基底核:意思決定に関与 – 動作原理は強化学習 • 海馬:エピソードの一時的な記憶 – 動作原理は自己連想ネットワーク • 小脳:運動を滑らかにする – 動作原理は教師あり学習(リキッドステートマシン 、パーセプトロン) • 扁桃体:情動と条件刺激の間の連合学習 各器官は大脳皮質を中心に 相互に接続 大脳皮質 小脳 基底核 扁桃体 海馬 すべての脳の機能は、実現方法がす でにわかっているのか? • No ! • 「実現方法が自明でない機能」を様々な専門 家の方々から具体的に引き出したい。 – この勉強会の個人的な目標の1つ。 – 全脳アーキテクチャ解明の非常に良いヒントにな るので。 ロードマップの必要性 • わかりやすい達成目標から構成されるロード マップがあれば研究は進みやすい。 • 純粋に思弁的に知能を目指すアプローチは、 ロードマップが抽象的になりがち。 • 一方、「全脳アーキテクチャ解明」はロード マップが作りやすい。 – 各器官の役割が比較的明確。 – 既存技術と比べた定量的な性能評価も可能。 応用: パターン認識 到達 目標: 大脳皮質モデルを中心とした ロードマップ(たたき台) ロボット制御 単純労働 高度な言語処理 様々な労働支援 階層型強化学習 思考・ナビゲーション 教師なし学習・認識 言語理解・発話 人間のような 知能 滑らかな運動 情動 要素 技術: 皮質・基底核連携モデル 皮質・基底核・海馬 連携モデル 全脳アーキテ クチャモデル 皮質・小脳連携モデル 大脳皮質 モデル 2013 言語野モデル 扁桃体モデル 2020 ? 時間 全脳アーキテクチャ俯瞰図(たたき台) すべての機能を統合するモジュール (全脳アーキテクチャモデル) 統合 言語理解・発話モジュール (言語野モデル) 滑らかな運動 モジュール (皮質・小脳連 携モデル) 思考・ナビゲーションモジュール (皮質・基底核・海馬連携モデル) 情動モ ジュール (扁桃体モ デル) 階層型強化学習モジュール (皮質・基底核連携モデル) 教師あり学習 モジュール (小脳モデル) 強化学習モ ジュール (大脳基底核 モデル) パーセプトロン、 強化学習 リキッドステー トマシン 部品 教師なし学習・認 識モジュール (大脳皮質 モデル) エピソード記憶 モジュール (海馬モデル) Deep learning, SOM, ベイジアン ネット 自己連想ネット ワーク、直交符 号化 連合学習 全脳アーキテクチャ俯瞰図(たたき台) すべての機能を統合するモジュール (全脳アーキテクチャモデル) 統合 言語理解・発話モジュール (言語野モデル) 滑らかな運動 モジュール (皮質・小脳連 携モデル) 思考・ナビゲーションモジュール (皮質・基底核・海馬連携モデル) 情動モ ジュール (扁桃体モ デル) 階層型強化学習モジュール (皮質・基底核連携モデル) 教師あり学習 モジュール (小脳モデル) 強化学習モ ジュール (大脳基底核 モデル) パーセプトロン、 強化学習 リキッドステー トマシン 部品 教師なし学習・認 識モジュール (大脳皮質 モデル) Deep learning, SOM, ベイジアン ネット エピソード記憶 モジュール (海馬モデル) これまでの 連合学習 自己連想ネット 計算論的神経科学 ワーク、直交符 号化 この研究の簡単ではないところ • 複数の分野の幅広い知識が必要。 – 神経科学、機械学習、認知科学 • 実装のむずかしさ。 全脳アーキテ クチャ勉強会 – 機械学習はテストしにくい。可視化しにくい。 – 実装ロジックが正しくても動かない。(NaN 、オーバー フロー、アンダーフロー) – 理論と実装が正しくても動かない。(局所解・過適合) – 複数の実装、テスト方法、可視化方法、たくさんのハ イパパラメタの組み合わせ爆発。 開発支援ツール BESOM-lab アルゴリズム開発支援ツール BESOM-lab Ver.3.0 • GUIツールキット • コンポーネントウ エア • 大脳皮質モデル BESOM • ソース(Java)を公 開中 「BESOM download」 http://staff.aist.go.jp/y-ichisugi/besom/download.html まとめ • 各器官の間の連携のモデルを作れば脳全体 の機能が再現できるはず。 運動野 前頭前野 言語野 視覚野 大脳皮質 基底核 扁桃体 海馬 小脳

© Copyright 2026